微软近期在人工智能领域迈出了重要一步,于4月30日正式发布了Phi-4-reasoning系列推理模型。这一系列模型专为应对复杂推理任务而设计,通过监督微调Phi-4,并利用o3-mini生成的高质量“可教导”提示数据集进行训练,实现了推理能力的显著提升。

本次发布的Phi-4-reasoning系列包含三款模型:Phi-4-reasoning、Phi-4-reasoning-plus以及Phi-4-mini-reasoning。据微软官方介绍,这些模型不仅继承了小型模型的高效特性,还在推理能力上取得了重大突破。它们通过推理时间扩展技术,能够处理需要多步骤分解和内部反思的复杂任务,尤其在数学推理和代理型应用中表现卓越。

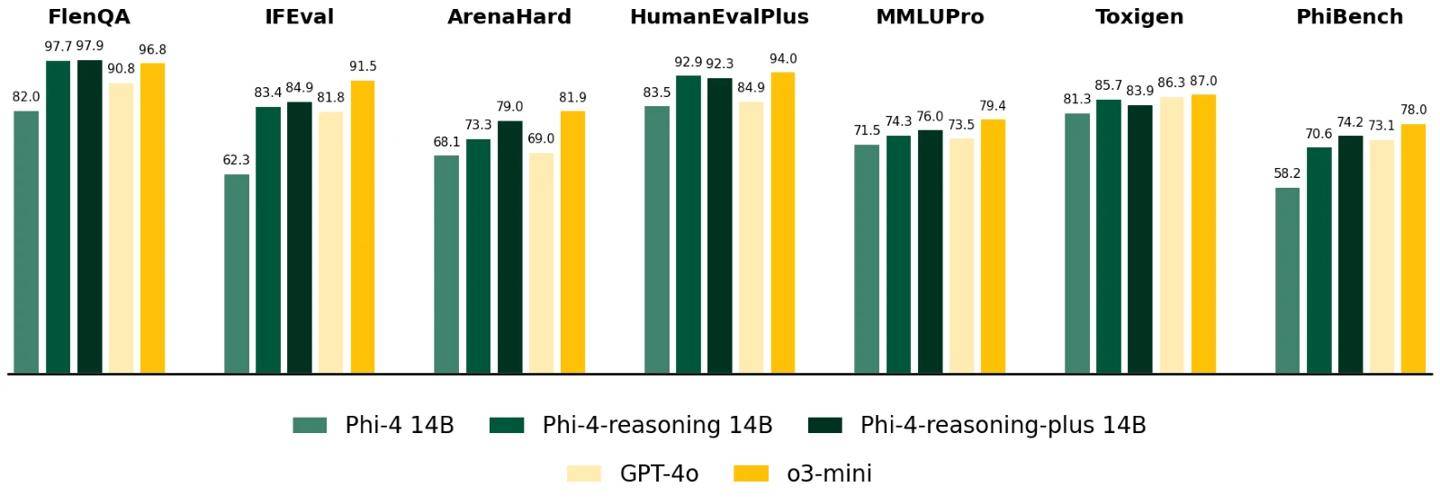

Phi-4-reasoning模型是一款拥有140亿参数的开源推理模型。它结合了OpenAI o3-mini的高质量推理演示数据,通过监督微调Phi-4,并利用额外计算资源,生成了详细的推理链条。这一特性使得Phi-4-reasoning在处理复杂推理任务时,能够展现出强大的解析和推理能力。

而Phi-4-reasoning-plus增强版则进一步通过强化学习技术提升了性能。与标准版相比,它的tokens用量增加了1.5倍,从而支持更高精度的推理任务。两款模型在数学推理和博士级科学问题测试中,均超越了OpenAI o1-mini和DeepSeek-R1-Distill-Llama-70B等模型,甚至在AIME 2025(美国数学奥林匹克资格赛)中击败了拥有6710亿参数的DeepSeek-R1满血模型。

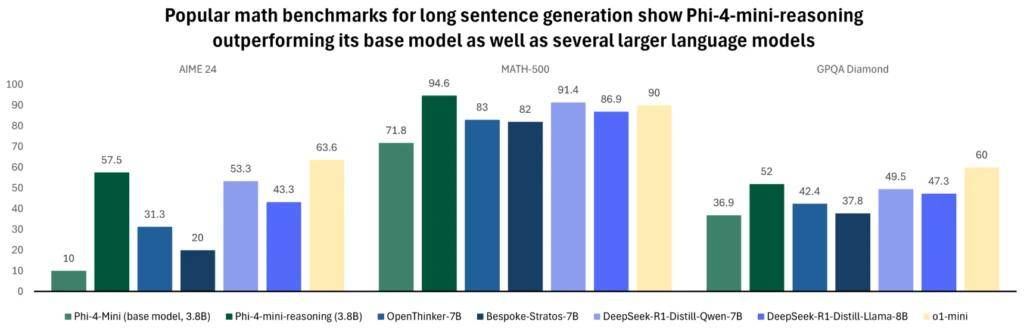

针对计算资源有限的环境,微软还推出了Phi-4-mini-reasoning模型。这是一款基于Transformer的紧凑型语言模型,专门优化用于数学推理。它通过DeepSeek-R1生成的合成数据进行了微调,能够在低延迟场景下提供高质量的逐步问题解决方案。这款模型覆盖了从中学到博士级的百万级多样化数学问题,非常适合教育应用、嵌入式辅导以及边缘设备部署。

在多项数学基准测试中,Phi-4-mini-reasoning模型凭借其3.8亿参数的表现,超越了OpenThinker-7B和Llama-3.2-3B-instruct等更大模型,甚至在部分测试中接近了OpenAI o1-mini的水平。这一成绩充分展示了Phi-4-mini-reasoning在高效性和准确性方面的卓越表现。

微软Phi-4-reasoning系列的发布,无疑为人工智能领域注入了新的活力。这一系列模型不仅在推理能力上取得了重大突破,还兼顾了高效性和实用性,为未来的应用和发展提供了广阔的空间。