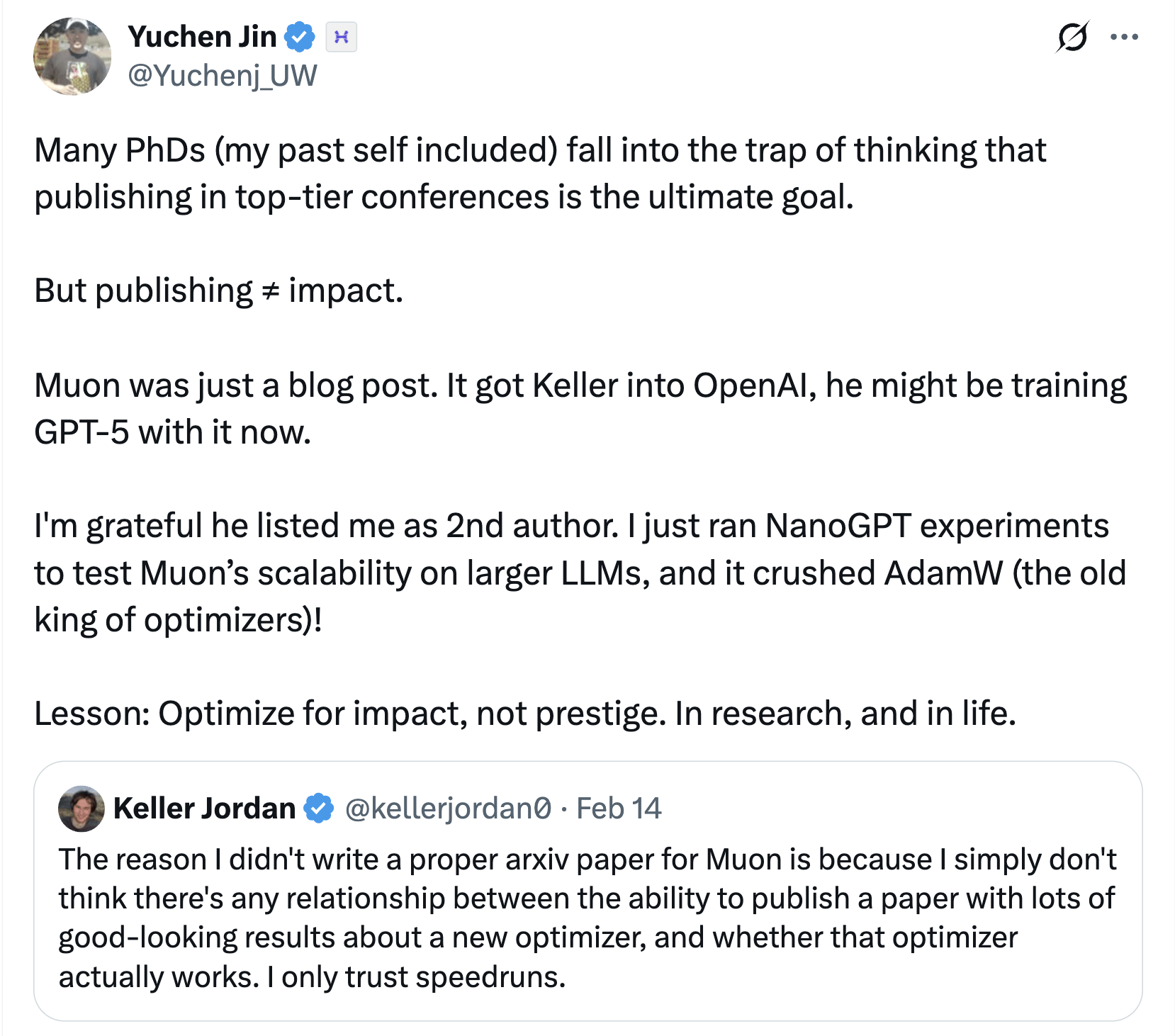

在AI领域,一篇博客文章往往难以引起广泛关注,但Keller Jordan的博客却是个例外。近日,AI云服务商Hyperbolic的联合创始人兼CTO Yuchen Jin在社交平台X上透露,Keller Jordan仅凭这篇博客就成功加入了OpenAI,并且有可能正在使用其中提出的神经网络隐藏层优化器Muon来训练GPT-5。

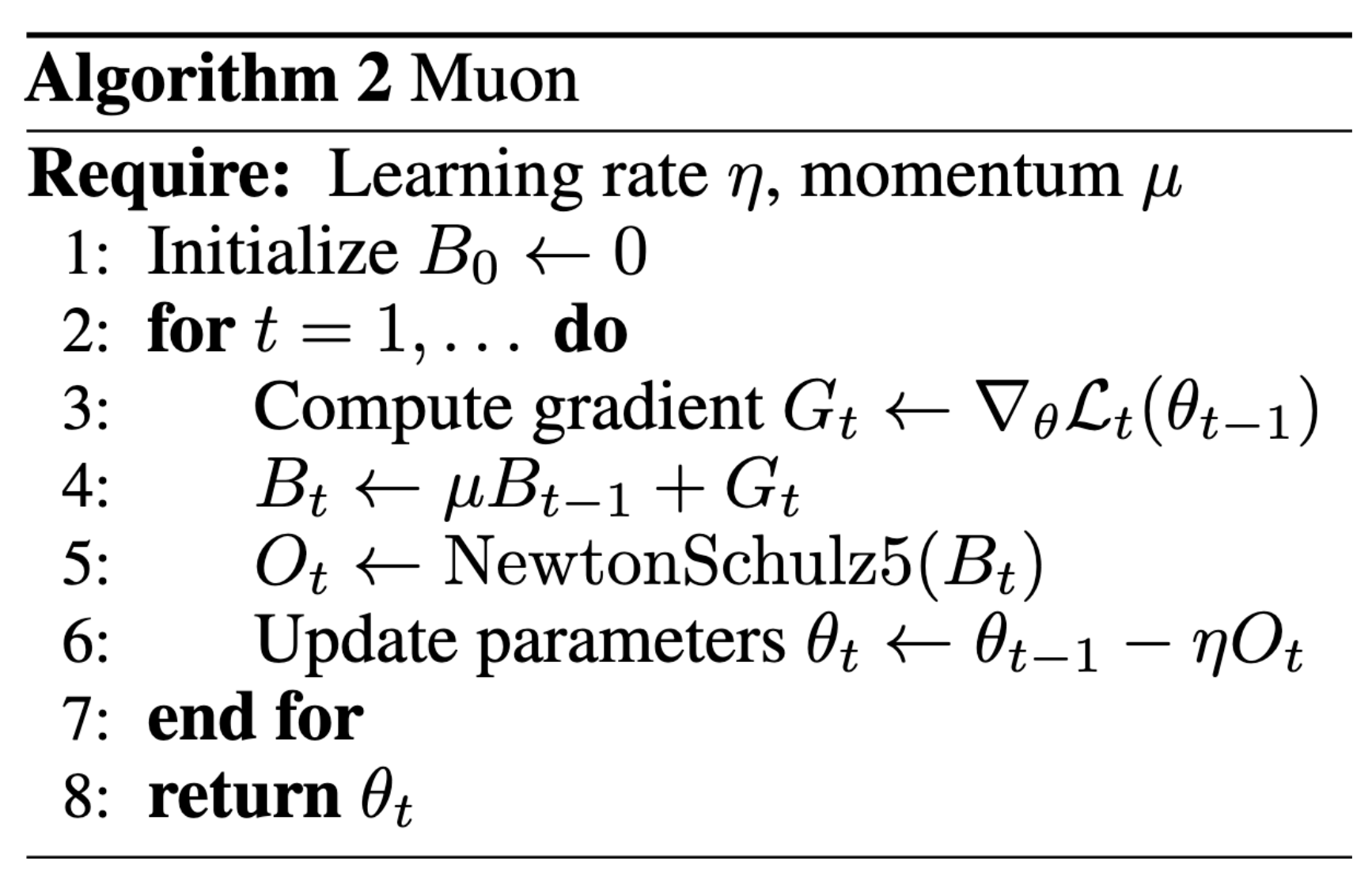

Jordan的这篇博客发布于2024年12月,题为《Muon:神经网络隐藏层的优化器》。在博客中,他详细介绍了Muon的设计原理及其在多个任务中的实证结果。据悉,Muon是一个针对神经网络隐藏层二维参数的优化器,它通过采用SGD-momentum生成的更新,并在应用之前对每个更新应用Newton-Schulz迭代作为后处理步骤,以实现更新矩阵的近似正交化。

Jordan在博客中指出,Muon在多个任务中均取得了显著的效果。例如,在CIFAR-10数据集上,它将训练速度记录提高到94%准确率,从3.3秒提高到2.6秒;在NanoGPT快速运行竞赛任务FineWeb上,它将训练速度记录提高至3.28 val loss,提高了1.35倍;在扩展到774M和1.5B参数的同时,Muon也继续显示了训练速度的提升。

Jordan在博客中还对神经网络优化研究文献进行了批判,指出其中充斥着大量已死的优化器。他认为,这些优化器声称能够击败AdamW,但往往以巨大的优势获胜,却从未被社区采用。Jordan认为,问题出在研究界,而非潜在的采用者。他犀利地指出,这项研究出了问题,并提出应该采用更高的证据标准来评估新的神经网络训练方法。

Jordan的观点和Muon的实证结果显然引起了OpenAI的注意。据Yuchen Jin透露,Jordan正是凭借这篇博客成功加入了OpenAI,并且有可能正在使用Muon来训练GPT-5。这一消息无疑让AI领域对Muon充满了期待。

从职场社交平台领英上也可以看到,Jordan确实是在2024年12月加入了OpenAI。这一时间点与博客的发布时间相吻合,进一步印证了Yuchen Jin的爆料。如果Jordan真的在使用Muon来训练GPT-5,那么这一技术很有可能成为GPT-5中的重要部分。

不过,Jordan也在博客中提出了一些尚未解决的问题。例如,Muon是否可以扩展到更大规模的训练?是否有可能在大型GPU集群中正确分布Muon使用的Newton-Schulz迭代?以及Muon是否仅适用于预训练,而不适用于微调或强化学习工作负载?这些问题仍有待进一步的研究和验证。

尽管如此,Muon的出现仍然为AI领域带来了新的希望和可能。它让人们看到了在神经网络优化方面还有巨大的潜力和空间等待挖掘。随着技术的不断进步和发展,相信未来会有更多像Muon这样的创新技术涌现出来,推动AI领域不断向前发展。