meta超级智能团队的成员毕树超近期在哥伦比亚大学和哈佛大学进行了两场关于人工智能的演讲,引发了广泛关注和讨论。他在演讲中回顾了人工智能(AI)70年的发展历程,从AlexNet引发的深度学习革命,到Transformer和Scaling Law推动大模型的爆发,再到强化学习与预训练的结合,逐步通向通用人工智能(AGI)。毕树超强调,智能并非人类独有,AGI的曙光已经出现。

毕树超指出,尽管十年前他对AGI持怀疑态度,但近年来他逐渐接受了这一理念,并坚信2025年AGI将成为现实。他在演讲中详细阐述了过去15年的技术进展、当前面临的挑战以及未来的发展趋势。

毕树超在meta超级智能实验室从事强化学习、预训练以及智能体研究。此前,他曾在OpenAI领导多模态研究,并担任YouTube Shorts的主要负责人。他拥有浙江大学数学学士学位,以及加州大学伯克利分校统计学硕士和数学博士学位。

毕树超的演讲特别提到了高质量人类数据的稀缺性。他指出,尽管人类文明已有几千年历史,但真正积累的高质量数据并不多,大部分文本数据已经消耗殆尽。因此,如何生成更多的数据成为关键问题。他认为,算力正变得越来越廉价,计算机与环境的交互或许能自动生成新的知识与数据,且速度可能远超人类。

毕树超分享了他对AGI研究的心路历程。起初,他对通用人工智能持怀疑态度,认为人脑是独特的,人类智能无可复制。但随着对AI理解的加深,他开始意识到模拟人脑的方式并非只有一种,计算机完全有能力模仿人类的学习方式。他认为,大脑只是生物进化的结果,虽然复杂,但本质上是一台“生物计算机”,并不比硅基计算机更神秘。更重要的是,系统是否具备足够的规模,而非结构的复杂程度,可能是决定智能的关键因素。

在哥伦比亚大学的演讲中,毕树超追溯了AI的思想根源。他提到,1948-1950年左右,Alan Turing提出了“机器能思考吗?”的问题,并主张设计一个简单模型,通过数据自主学习,尽量减少人为预设的结构。毕树超指出,这正是机器学习的核心。

他回顾了自监督学习、深度网络以及Transformer等里程碑式架构的兴起,并展示了计算能力和数据规模的提升如何带来性能的飞跃。毕树超特别提到了AlexNet、Word2Vec、GAN、Adam优化器和ResNet等关键技术,这些技术为深度学习革命奠定了基础。

毕树超还提到了过参数化不是bug,而是feature的颠覆性发现。他指出,在深度学习模型中,参数数量远超过数据点数量并不会导致过拟合,反而有助于模型选择泛化性最优的解。这一发现打破了传统统计分析领域的认知。

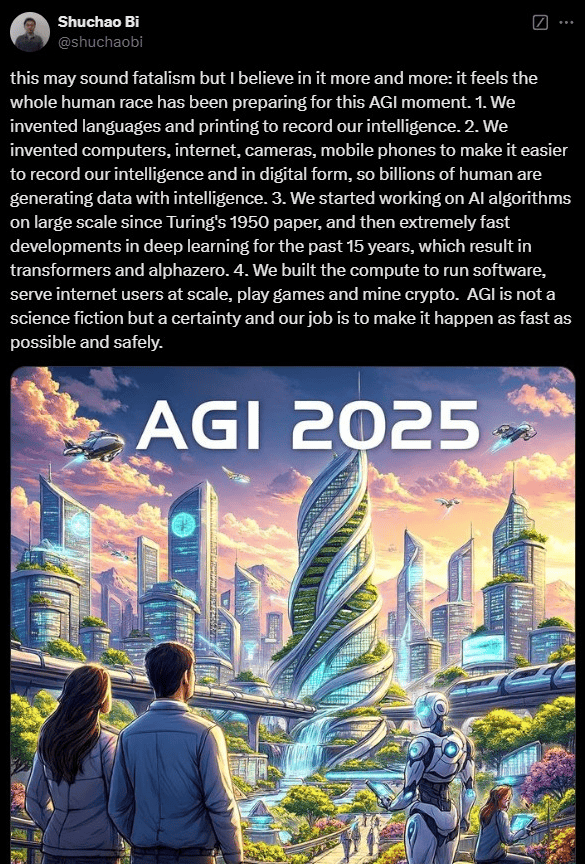

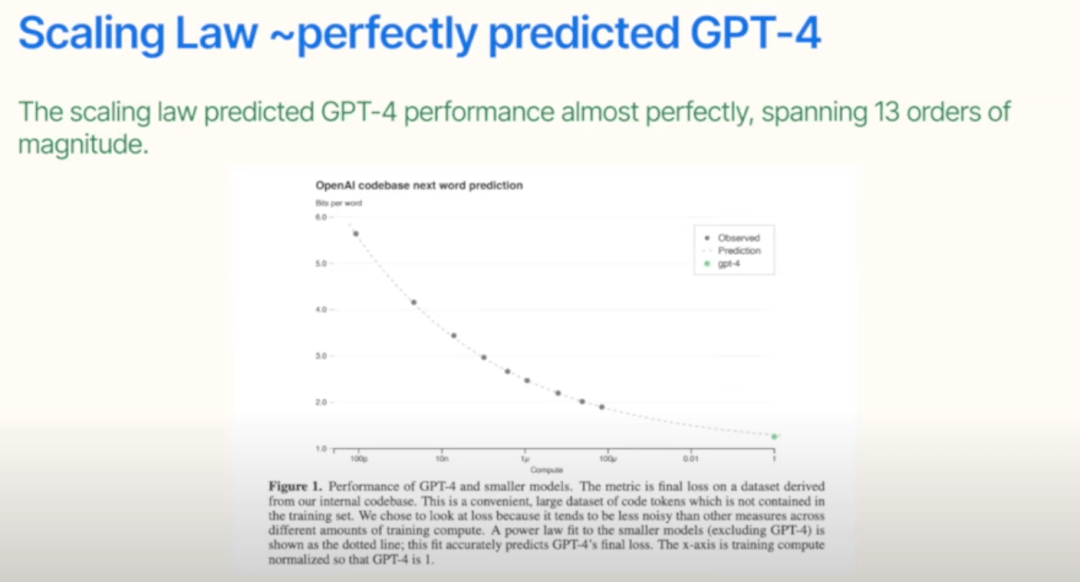

毕树超认为,Transformer架构是过去十年最重要的架构之一,它高度可并行化、数据效率高,且扩展性极佳。Transformer的出现解决了之前模型的局限性,推动了AI技术的发展。他特别提到了GPT系列模型,认为这些模型通过零样本或少样本学习完成任务,展现了通用人工智能的本质。

毕树超还探讨了强化学习在AI发展中的作用。他指出,深度强化学习从2015年开始逐渐兴起,AlphaGo的出现让人们意识到AI模型真的具备智能。然而,强化学习在现实中的应用一度受限,直到与预训练模型结合,才真正改变了局面。他强调,未来要构建真正的AGI乃至超人工智能(ASI),强化学习必须发挥更大的作用。

毕树超在演讲中表示,每隔几个月,人们就能看到曾经被认为不可能的事情成为现实。他认为,很多我们以为的不可能,其实只是知识的局限。他鼓励人们重新审视所有仍然认为不可能的事情,并期待AI技术的未来发展。