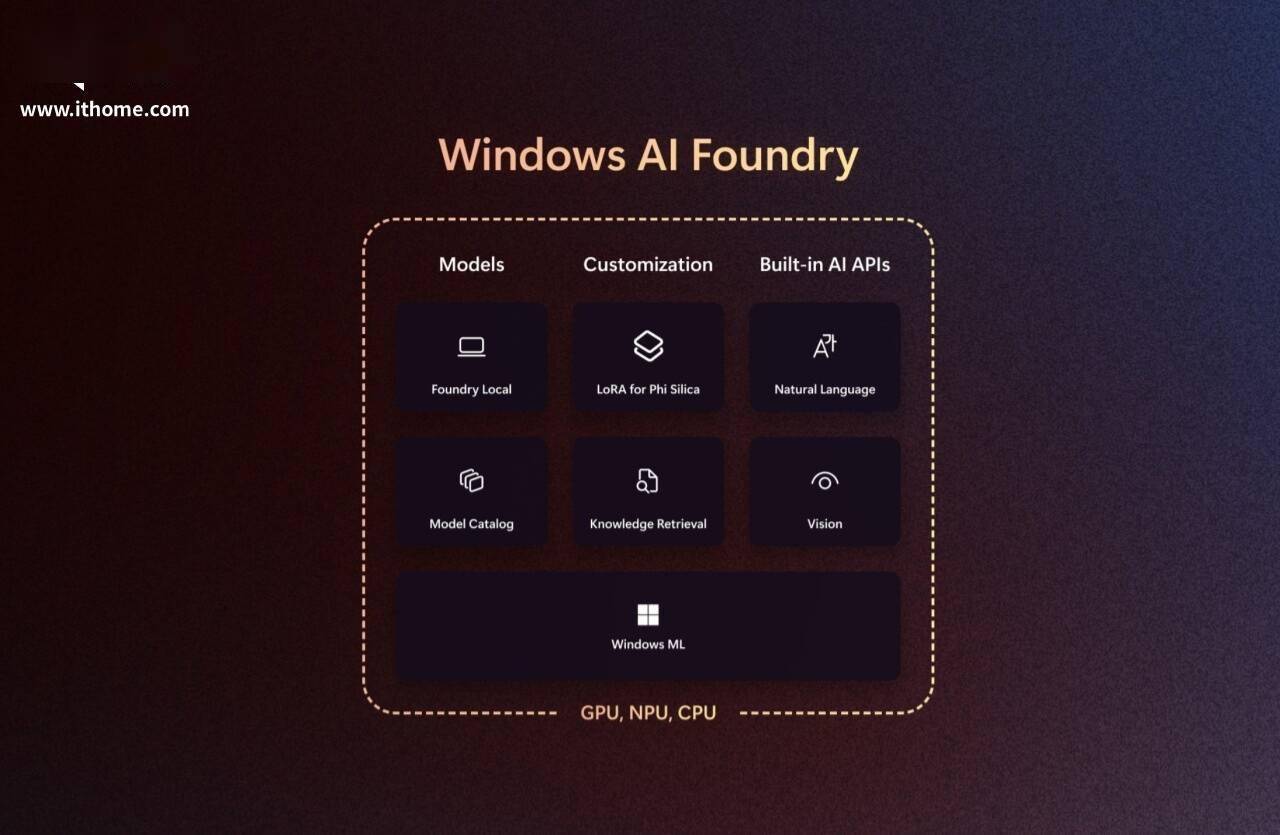

在近日举行的Build 2025开发者盛会上,微软公司震撼发布了一系列针对Windows平台的AI开发新工具和特性,其中最引人注目的当属Windows AI Foundry这一全新统一平台的问世。该平台旨在为本地AI开发提供前所未有的强大支持,通过整合Windows Copilot Runtime及多项创新功能,进一步推动Windows生态内AI应用的蓬勃发展。

Windows AI Foundry的推出,标志着微软在本地AI开发领域迈出了关键步伐。该平台不仅集成了已在Windows平台上为本地AI应用提供支持的Windows Copilot Runtime,还通过Windows AI API和Windows机器学习(ML)功能,让AI模型得以在本地持续高效运行。而Windows AI Foundry的拓展,则为开发者提供了即用型AI API,这些API由内置AI模型驱动,满足开发者多样化的本地AI应用开发需求。

该平台的一大亮点在于其提供的定制Windows内置模型工具,开发者可针对自身应用的特定需求对模型进行优化调整。Windows AI Foundry还支持从Azure AI Foundry引入开源模型,极大地丰富了开发者可使用的模型资源。同时,它还配备了一个推理运行时,让开发者能够轻松地将自己开发的模型集成到应用中。

在AI模型的集成方面,Windows AI Foundry展现出了卓越的兼容性。它不仅整合了来自Azure Foundry Local的AI模型,还支持其他模型目录,如Ollama和NVIDIA NIMs。微软自家的Foundry Local模型目录则提供经过优化的AI模型,这些模型能够在CPU、GPU和NPU等多种硬件平台上高效运行。开发者只需通过简单的命令即可浏览、下载和测试与设备兼容的模型,并利用Foundry Local SDK轻松将Foundry Local集成到自己的应用中,从而大大降低了开发难度和时间成本。

Windows ML作为Windows内置的AI推理运行时,在Windows AI Foundry中扮演着重要角色。它基于DirectML开发,能够在AMD、Intel、NVIDIA和Qualcomm等多种芯片平台上高效运行。Windows ML的出现极大地简化了模型部署流程,使开发者无需担忧未来硬件更新带来的兼容性问题。该运行时能够自动更新所有必要的依赖项,并在后台自动适配新的芯片架构,确保应用的稳定性和性能。

微软还宣布了对LoRA(Low-Rank Adaptation)技术的支持。这一技术能够在Phi Silica模型上实现对模型参数的小部分微调,通过自定义数据进行微调,LoRA能够显著提升模型在特定任务上的性能表现。目前,LoRA已进入公开预览阶段,并已在Snapdragon X系列NPU上实现支持。未来几个月内,LoRA还将扩展到Intel和AMD的Copilot+ PC上,为更多开发者提供这一高效的微调工具。

微软还推出了新的语义搜索API,帮助开发者在其应用中创建AI驱动的搜索体验。这些API支持本地运行,并集成了RAG(Retrieval-Augmented Generation)技术,能够提供更加智能和高效的搜索结果。目前,语义搜索API已在所有Copilot+ PC上进入私有预览阶段,开发者可利用这些API将AI驱动的搜索功能集成到自己的应用中,为用户提供更加个性化的搜索体验。