在近日的一场行业交流活动中,范式智能CEO戴文渊发表了关于国产算力发展的深度见解。他指出,当前国内AI应用生态过度依赖英伟达体系,超过99%的AI工作均在其框架下完成,这一现象不仅体现在技术层面,更折射出国产信创生态建设的紧迫性。

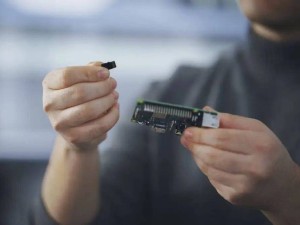

戴文渊以手机应用生态作类比:若苹果手机拥有200万个应用,而国产手机仅50个,用户自然会因生态缺失而放弃选择。这种差距在GPU领域同样显著——英伟达CUDA体系拥有1.8万个算子,而国产GPU平均仅数百个,核心数量差距达20倍。更严峻的是,多数企业采购国产卡并非出于性能优势,而是作为英伟达产品的替代方案,这种"备胎"心态制约了国产算力的真正突破。

针对行业普遍追求的"万卡集群"现象,戴文渊提出不同观点:头部企业确实需要超大规模算力集群,但90%的商业开发者更关注单卡利用率。他透露,某央企搭建的万卡集群实际利用率极低,开发者甚至只能使用万分之一的算力。这种两极分化要求算力供给必须实现差异化——既满足头部企业的极限需求,也要为中小企业提供"一张卡跑万个模型"的灵活方案。

范式智能正通过技术革新破解这一难题。其推出的信创魔盒Model Hub XC已汇聚超万个适配国产GPU的模型,虽然数量仅为英伟达生态的百分之一,但每周新增适配量达2500个,增速显著。戴文渊透露,公司计划今年将模型数量提升至10万级,明年追平国际主流生态,同时通过异构VGPU技术实现不同厂商硬件的统一调度,显著提升资源利用率。

在算力服务层面,范式智能联合曦望推出的Fancy Cloud平台已实现关键突破。该平台集成VGPU技术与开发工具链,可同时调用英伟达及国产GPU资源,为客户提供超万个垂直领域模型。更引人注目的是其性价比策略——通过与曦望合作,平台计划将算力成本降至每百万token一分钱,较国际同类服务降低90%以上。

戴文渊强调,国产算力突破需要软硬件协同创新。范式智能将持续完善开发平台生态,同时呼吁更多企业参与信创生态建设。他特别指出,垂直模型的价值正在凸显,OpenAI关闭专业领域服务印证了通用模型在细分场景的局限性,而范式在二十多个行业积累的近万个垂直模型,将成为国产算力生态的重要竞争力。