谷歌DeepMind团队近日宣布,在Gemini 3 Flash模型中引入了一项突破性的“智能体视觉”功能。这一创新旨在解决传统AI模型在图像处理中的固有局限,通过主动调查的方式提升视觉理解的准确性。

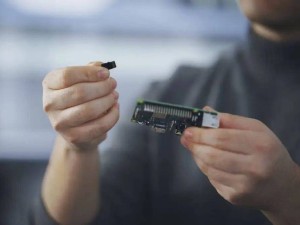

传统AI模型在处理图像时,往往仅进行一次静态扫描。这种方式容易遗漏关键细节,例如芯片序列号或远处路牌上的信息,导致模型只能依赖猜测生成答案。Gemini 3 Flash的新功能则通过模拟人类的“思考、行动、观察”循环,将视觉理解转化为一个动态过程。模型不再被动接收信息,而是主动制定计划、操作图像并验证结果,从而确立答案的视觉证据。

“智能体视觉”的核心机制是一个闭环系统。在“思考”阶段,模型分析用户查询和初始图像,制定多步操作计划;随后进入“行动”阶段,模型生成并执行Python代码,对图像进行裁剪、旋转或标注等操作,或进行边界框计算等分析;最后在“观察”阶段,变换后的图像被追加到模型的上下文窗口中,供进一步验证。这一过程使模型能够利用更新后的数据和更佳的语境进行二次检查,最终生成基于事实的回复。

引入代码执行能力后,Gemini 3 Flash在多项视觉基准测试中的表现显著提升,质量提高了5%至10%。例如,在建筑图纸验证平台PlanCheckSolver.com上,该功能通过代码裁剪并分析屋顶边缘等高分辨率细节,使准确率提升了5%。在处理视觉数学问题时,模型不再依赖概率猜测,而是通过编写代码识别原始数据并调用Matplotlib库绘制精确图表,有效解决了多步视觉算术中常见的“幻觉”问题。

目前,Gemini 3 Flash已能够隐式决定何时放大细节以获取更准确的信息。谷歌DeepMind团队表示,未来版本将进一步优化,无需用户显式提示即可自动执行旋转图像或视觉运算等操作,从而提供更智能、更高效的视觉理解服务。